Durante la pandemia, Google si è concentrato sulla fornitura di informazioni accurate per aiutare le persone a rimanere in salute. Nell’ultimo anno, le persone hanno utilizzato Ricerca Google e Maps per trovare dove potevano ottenere un vaccino contro il Covid quasi due miliardi di volte:

Durante la pandemia, Google si è concentrato sulla fornitura di informazioni accurate per aiutare le persone a rimanere in salute. Nell’ultimo anno, le persone hanno utilizzato Ricerca Google e Maps per trovare dove potevano ottenere un vaccino contro il Covid quasi due miliardi di volte:

“La tecnologia di previsione delle inondazioni di Google” – rendono noto dall’azienda – “ha inviato avvisi di inondazione a 23 milioni di persone in India e Bangladesh l’anno scorso. Abbiamo anche ampliato la nostra tecnologia di previsione delle inondazioni per aiutare le persone a rimanere al sicuro di fronte ai disastri naturali. Durante la stagione dei monsoni dello scorso anno, i nostri avvisi di inondazione hanno notificato più di 23 milioni di persone in India e Bangladesh. E stimiamo che ciò abbia supportato l’evacuazione tempestiva di centinaia di migliaia di persone. In Ucraina, abbiamo collaborato con il governo per dispiegare rapidamente allarmi antiaerei. Ad oggi, abbiamo inviato centinaia di milioni di avvisi per aiutare le persone a mettersi in salvo. A marzo sono stato in Polonia , dove hanno cercato rifugio milioni di ucraini. La popolazione di Varsavia è aumentata di quasi il 20% poiché le famiglie ospitano i rifugiati nelle loro case e le scuole accolgono migliaia di nuovi studenti. Quasi tutti i dipendenti di Google con cui ho parlato ospitavano qualcuno”.

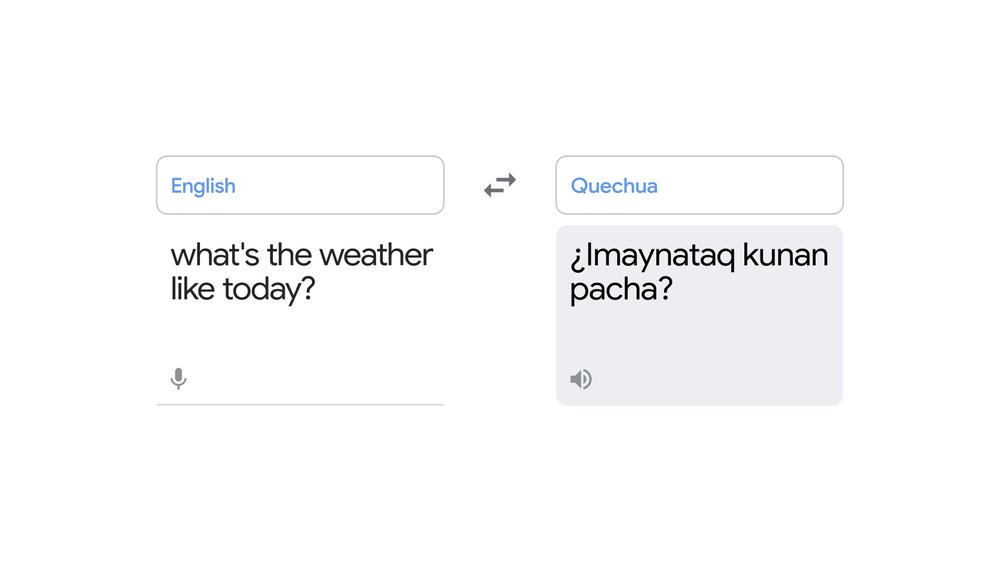

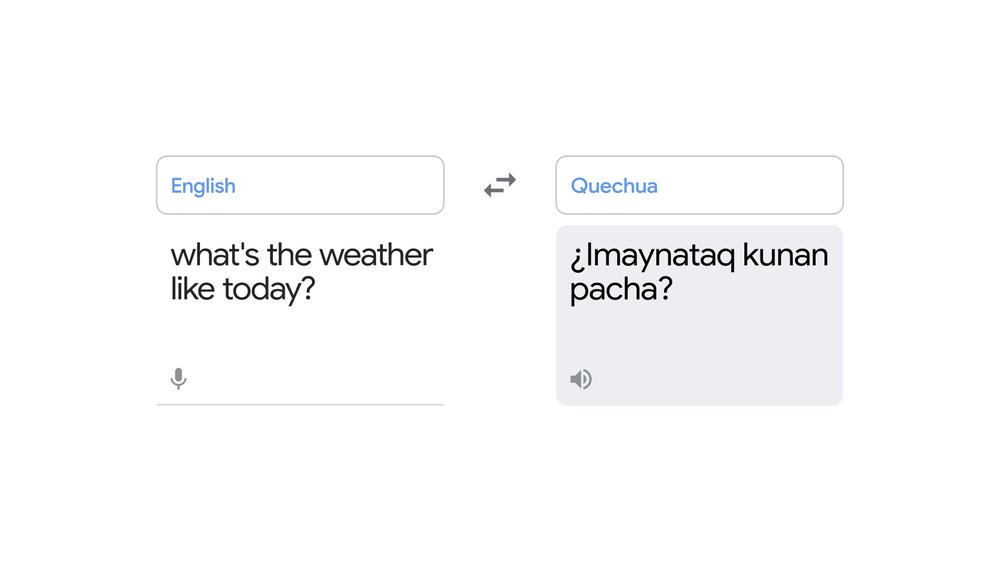

Aggiunta di altre 24 lingue a Google Translate

“Nei paesi di tutto il mondo, Google Translate è stato uno strumento fondamentale per i nuovi arrivati e i residenti che cercano di comunicare tra loro. Siamo orgogliosi di come stia aiutando gli ucraini a trovare un po’ di speranza e connessione fino a quando non saranno in grado di tornare di nuovo a casa” – ricordano sempre da Google.

“Con i progressi dell’apprendimento automatico, siamo in grado di aggiungere lingue come il quechua a Google Translate. La traduzione in tempo reale è una testimonianza di come la conoscenza e l’informatica si uniscono per migliorare la vita delle persone. Più persone utilizzano Google Translate che mai, ma dobbiamo ancora lavorare per renderlo universalmente accessibile. C’è una lunga coda di lingue che oggi sono sottorappresentate sul web e tradurle è un problema tecnico difficile. Questo perché i modelli di traduzione sono generalmente addestrati con testo bilingue, ad esempio la stessa frase sia in inglese che in spagnolo. Tuttavia, non c’è abbastanza testo bilingue pubblicamente disponibile per ogni lingua. Quindi, con i progressi nell’apprendimento automatico, abbiamo sviluppato un approccio monolingue in cui il modello impara a tradurre una nuova lingua senza mai vederne una traduzione diretta. Collaborando con persone madrelingua e istituzioni, abbiamo riscontrato che queste traduzioni erano di qualità sufficiente per essere utili e continueremo a migliorarle” – hanno proseguito da Google.

“Stiamo aggiungendo 24 nuove lingue a Google Translate. Oggi sono lieto di annunciare che stiamo aggiungendo 24 nuove lingue a Google Translate , comprese le prime lingue autoctone delle Americhe. Insieme, queste lingue sono parlate da oltre 300 milioni di persone. Innovazioni come questa stanno alimentando un cambiamento radicale nel modo in cui accediamo alla conoscenza e utilizziamo i computer” – hanno detto da Google.

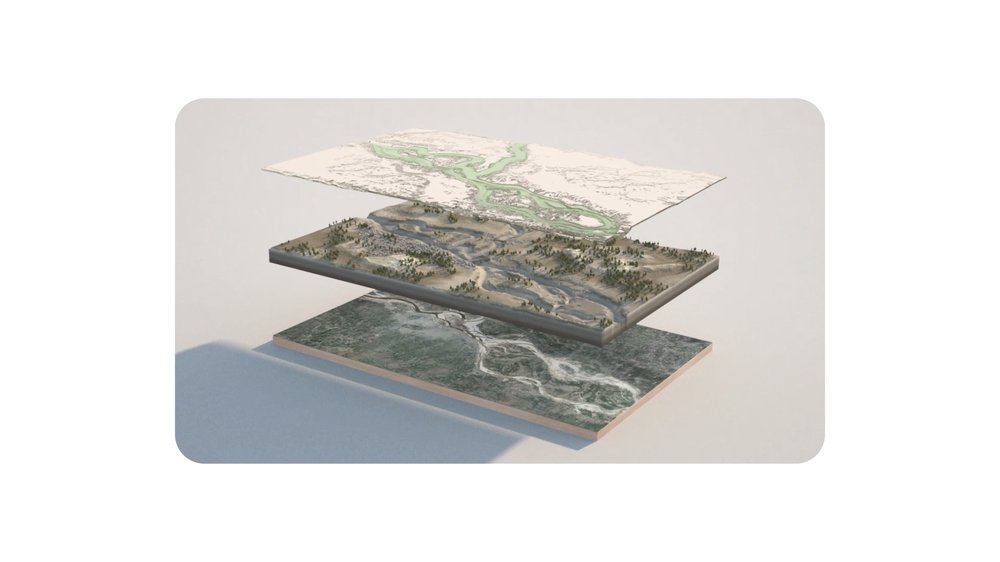

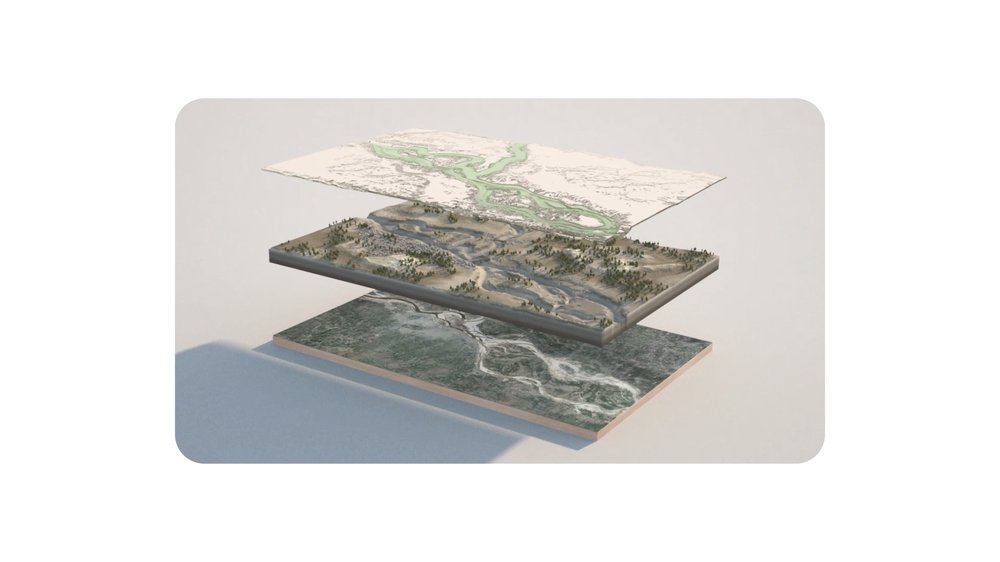

Portare Google Maps al livello successivo

“Molto di ciò che è conoscibile nel nostro mondo va oltre il linguaggio: è nelle informazioni fisiche e geospaziali che ci circondano. Per più di 15 anni, Google Maps ha lavorato per creare rappresentazioni ricche e utili di queste informazioni per aiutarci a navigare. I progressi nell’IA stanno portando questo lavoro a un livello superiore, sia che si tratti di espandere la nostra copertura ad aree remote o di reinventare come esplorare il mondo in modi più intuitivi” – sostiene Google.

“I progressi nell’IA stanno aiutando a mappare le aree remote e rurali. In tutto il mondo, ad oggi, abbiamo mappato circa 1,6 miliardi di edifici e oltre 60 milioni di chilometri di strade. In precedenza, alcune aree remote e rurali erano difficili da mappare, a causa della scarsità di immagini di alta qualità e di tipi di edifici e terreni distinti. Per affrontare questo problema, utilizziamo la visione artificiale e le reti neurali per rilevare edifici su larga scala dalle immagini satellitari. Di conseguenza, da luglio 2020 abbiamo aumentato di 5 volte il numero di edifici su Google Maps in Africa, da 60 milioni a quasi 300 milioni. Quest’anno abbiamo anche raddoppiato il numero di edifici mappati in India e Indonesia. A livello globale, oltre il 20% degli edifici su Google Maps è stato rilevato utilizzando queste nuove tecniche. Abbiamo fatto un ulteriore passo avanti e reso pubblicamente disponibile il set di dati degli edifici in Africa. Organizzazioni internazionali come le Nazioni Unite e la Banca mondiale lo stanno già utilizzando per comprendere meglio la densità della popolazione e per fornire supporto e assistenza di emergenza” – dichiarano da Google.

“La visualizzazione immersiva in Google Maps fonde insieme immagini aeree e a livello stradale. Stiamo anche introducendo nuove funzionalità in Maps. Utilizzando i progressi nella mappatura 3D e nell’apprendimento automatico, stiamo fondendo miliardi di immagini aeree e a livello stradale per creare una nuova rappresentazione ad alta fedeltà di un luogo. Queste tecnologie rivoluzionarie si stanno unendo per alimentare una nuova esperienza in Maps chiamata visualizzazione immersiva : ti consente di esplorare un luogo come mai prima d’ora. Andiamo a Londra e diamo un’occhiata. Supponiamo che tu abbia intenzione di visitare Westminster con la tua famiglia. Puoi accedere a questa vista immersiva direttamente da Maps sul tuo telefono e puoi esplorare i luoghi d’interesse… ecco l’Abbazia di Westminster. Se stai pensando di andare al Big Ben, puoi controllare se c’è traffico, quanto è occupato e persino vedere le previsioni del tempo. E se stai cercando di mangiare un boccone durante la tua visita, puoi dare un’occhiata ai ristoranti nelle vicinanze e dare un’occhiata all’interno” – dicono da Google.

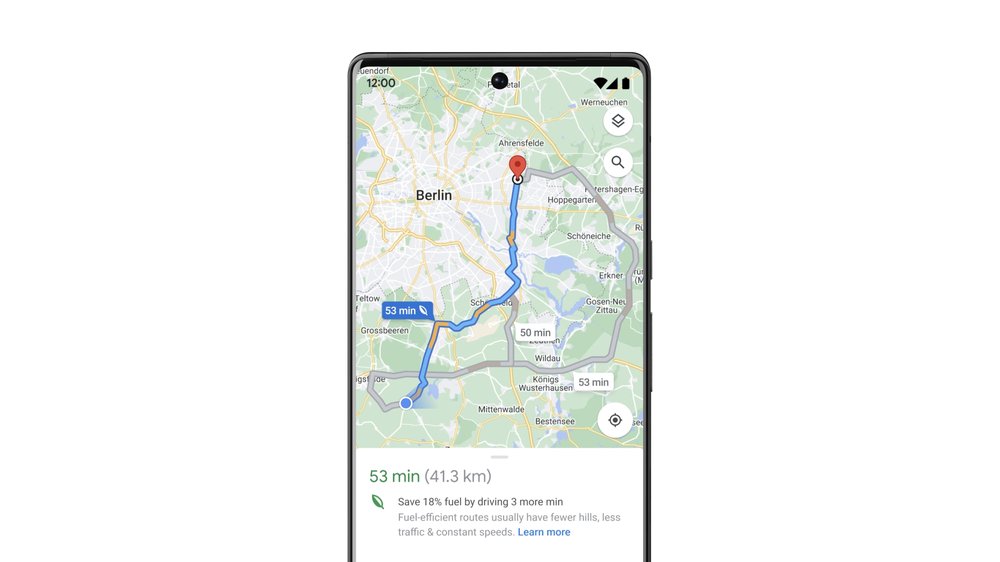

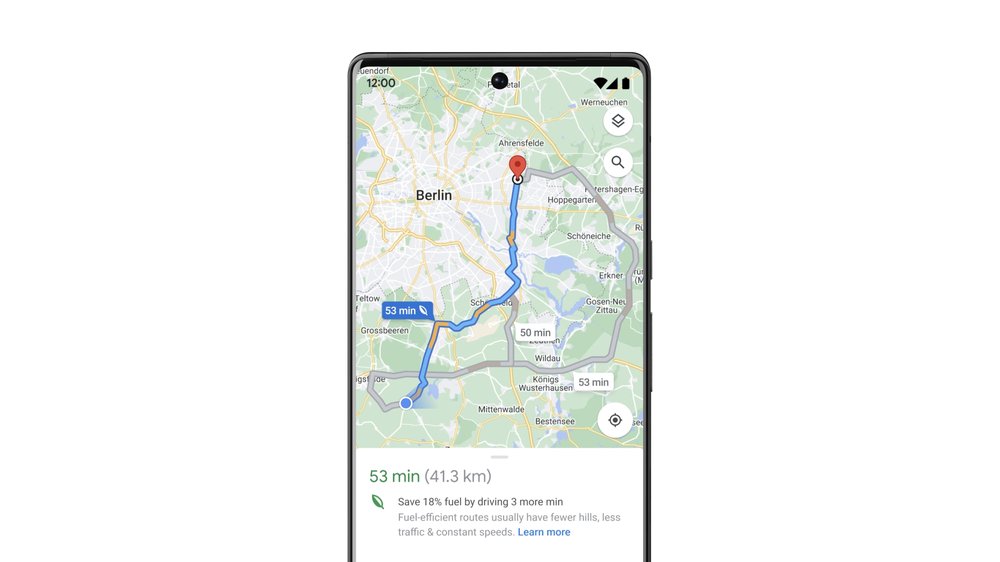

“La cosa sorprendente è che non è un drone che vola nel ristorante: utilizziamo il rendering neurale per creare l’esperienza dalle sole immagini. E Google Cloud Immersive Stream consente a questa esperienza di funzionare praticamente su qualsiasi smartphone. Questa funzione inizierà a essere implementata in Google Maps per alcune città a livello globale entro la fine dell’anno. Un altro grande miglioramento di Maps è il percorso ecologico. Lanciato lo scorso anno, ti mostra il percorso più efficiente in termini di consumo di carburante, offrendoti la possibilità di risparmiare denaro sul gas e ridurre le emissioni di carbonio. Percorsi ecologici sono già stati lanciati negli Stati Uniti e in Canada e le persone li hanno utilizzati per percorrere circa 86 miliardi di miglia, contribuendo a risparmiare circa mezzo milione di tonnellate di emissioni di carbonio, l’equivalente di togliere dalla strada 100.000 auto” – hanno dichiarato da Google.

“Le rotte ecologiche si espanderanno in Europa entro la fine dell’anno. Sono felice di condividere che stiamo espandendo questa funzione in più luoghi, inclusa l’Europa entro la fine dell’anno. In questo esempio di Berlino, potresti ridurre il consumo di carburante del 18% percorrendo un percorso che è solo tre minuti più lento. Queste piccole decisioni hanno un grande impatto su larga scala. Con l’espansione in Europa e oltre, stimiamo che i risparmi di emissioni di carbonio raddoppieranno entro la fine dell’anno. E abbiamo aggiunto una funzione simile a Google Voli. Quando cerchi voli tra due città, ti mostriamo anche stime delle emissioni di carbonio insieme ad altre informazioni come prezzo e orari, rendendo facile scegliere un’opzione più ecologica. Queste funzionalità eco-compatibili in Maps and Flights fanno parte del nostro obiettivo di consentire a 1 miliardo di persone di fare scelte più sostenibili attraverso i nostri prodotti e siamo entusiasti dei progressi qui” – hanno sottolineato da Google.

Nuove funzionalità di YouTube per aiutare le persone ad accedere facilmente ai contenuti video

“Oltre a Maps, il video sta diventando una parte ancora più fondamentale del modo in cui condividiamo informazioni, comunichiamo e impariamo. Spesso, quando visiti YouTube, stai cercando un momento specifico in un video e vogliamo aiutarti ad arrivarci più velocemente. L’anno scorso abbiamo lanciato i capitoli generati automaticamente per facilitare il passaggio alla parte che ti interessa di più. Questo è ottimo anche per i creatori perché consente loro di risparmiare tempo nella creazione di capitoli. Ora stiamo applicando la tecnologia multimodale di DeepMind. Utilizza contemporaneamente testo, audio e video per generare automaticamente capitoli con maggiore precisione e velocità. Con questo, ora abbiamo l’obiettivo di 10 volte il numero di video con capitoli generati automaticamente, da otto milioni di oggi, a 80 milioni nel prossimo anno. Spesso il modo più veloce per avere un’idea del contenuto di un video è leggerne la trascrizione, quindi utilizziamo anche modelli di riconoscimento vocale per trascrivere i video. Le trascrizioni video sono ora disponibili per tutti gli utenti Android e iOS” – hanno detto da Google.

“Sottotitoli tradotti automaticamente su YouTube. Successivamente, stiamo portando i sottotitoli tradotti automaticamente su YouTube sui dispositivi mobili. Ciò significa che gli spettatori ora possono tradurre automaticamente i sottotitoli dei video in 16 lingue e i creatori possono ampliare il loro pubblico globale. Il prossimo mese espanderemo anche i sottotitoli tradotti automaticamente ai contenuti ucraini di YouTube, parte del nostro più ampio sforzo per aumentare l’accesso a informazioni accurate sulla guerra” – hanno specificato da Google.

Aiutare le persone a essere più efficienti con Google Workspace

“Proprio come utilizziamo l’IA per migliorare le funzionalità di YouTube, la stiamo integrando nei nostri prodotti Workspace per aiutare le persone a essere più efficienti. Che tu lavori per una piccola impresa o una grande istituzione, è probabile che passi molto tempo a leggere documenti. Forse hai sentito quell’ondata di panico quando ti rendi conto di avere un documento di 25 pagine da leggere prima di una riunione che inizierà tra cinque minuti. In Google, ogni volta che ricevo un documento lungo o un’e-mail, cerco un TL;DR in alto: TL;DR è l’abbreviazione di “Troppo lungo, non letto”. E ci ha fatto pensare, la vita non sarebbe migliore se più cose avessero un TL;DR? Ecco perché abbiamo introdotto il riepilogo automatico per Google Documenti. Utilizzando uno dei nostri modelli di machine learning per il riepilogo del testo, Google Docs analizzerà automaticamente le parole ed estrarrà i punti principali. Questo segna un grande balzo in avanti per l’elaborazione del linguaggio naturale. La sintesi richiede la comprensione di passaggi lunghi, la compressione delle informazioni e la generazione del linguaggio, che erano al di fuori delle capacità anche dei migliori modelli di machine learning. E i documenti sono solo l’inizio. Stiamo lanciando il riepilogo per altri prodotti in Workspace. Arriverà su Google Chat nei prossimi mesi, fornendo un utile riassunto delle conversazioni in chat, così puoi passare direttamente a una chat di gruppo o guardare indietro ai punti salienti” – hanno detto da Google.

“Nei prossimi mesi porteremo il riepilogo su Google Chat. E stiamo lavorando per portare la trascrizione e il riepilogo anche su Google Meet in modo che tu possa recuperare il ritardo su alcune riunioni importanti che ti sei perso” – hanno dichiarato da Google.

Miglioramenti visivi su Google Meet

“Ovviamente ci sono molti momenti in cui vuoi davvero essere in una stanza virtuale con qualcuno. Ed è per questo che continuiamo a migliorare la qualità audio e video, ispirandoci a Project Starline . Abbiamo presentato Project Starline all’I/O l’anno scorso. E lo abbiamo testato negli uffici di Google per ottenere feedback e migliorare la tecnologia per il futuro. E nel processo, abbiamo appreso alcune cose che possiamo applicare in questo momento a Google Meet. Elaborazione delle immagini basata sull’apprendimento automatico ispirata a Starline per migliorare automaticamente la qualità dell’immagine in Google Meet. E funziona su tutti i tipi di dispositivi per farti apparire al meglio ovunque tu sia” – hanno specificato da Google.

“L’elaborazione delle immagini basata sull’apprendimento automatico migliora automaticamente la qualità dell’immagine in Google Meet. Stiamo anche portando in Meet un’illuminazione virtuale di qualità da studio. Puoi regolare la posizione e la luminosità della luce, così sarai ancora visibile in una stanza buia o seduto davanti a una finestra. Stiamo testando questa funzione per garantire che tutti appaiano come se stessi, continuando il lavoro che abbiamo svolto con Real Tone su telefoni Pixel e Monk Scale“ – hanno detto da Google.

Questi sono solo alcuni dei modi in cui l’IA sta migliorando i nostri prodotti: rendendoli più utili, più accessibili e offrendo nuove funzionalità innovative per tutti.

Oggi all’I/O Prabhakar Raghavan ha condiviso come aiutiamo le persone a trovare informazioni utili in modi più intuitivi su Ricerca.

Rendere accessibile la conoscenza attraverso l’informatica

“Abbiamo parlato di come stiamo migliorando l’accesso alla conoscenza come parte della nostra missione: da una migliore traduzione linguistica a migliori esperienze di ricerca attraverso immagini e video, a esplorazioni più ricche del mondo utilizzando Maps. Ora ci concentreremo su come rendere questa conoscenza ancora più accessibile attraverso l’informatica. Il viaggio che abbiamo intrapreso con l’informatica è entusiasmante. Ogni passaggio, dal desktop al Web, dai dispositivi mobili ai dispositivi indossabili e all’informatica ambientale, ha reso la conoscenza più utile nella nostra vita quotidiana. Per quanto utili siano i nostri dispositivi, abbiamo dovuto lavorare sodo per adattarci a loro. Ho sempre pensato che i computer dovessero adattarsi alle persone, non viceversa. Continuiamo a spingerci per fare progressi qui. Ecco come stiamo rendendo l’informatica più naturale e intuitiva con l’ Assistente Google” – hanno detto da Google.

Presentazione di LaMDA 2 e AI Test Kitchen

“Una demo di LaMDA, il nostro modello di linguaggio generativo per l’applicazione del dialogo, e AI Test Kitchen. Lavoriamo continuamente per migliorare le nostre capacità di conversazione . La conversazione e l’elaborazione del linguaggio naturale sono metodi efficaci per rendere i computer più accessibili a tutti. E i modelli linguistici di grandi dimensioni sono fondamentali per questo. L’anno scorso abbiamo introdotto LaMDA , il nostro modello di linguaggio generativo per applicazioni di dialogo in grado di conversare su qualsiasi argomento. Oggi siamo lieti di annunciare LaMDA 2, la nostra IA conversazionale più avanzata di sempre. Siamo all’inizio di un percorso per rendere modelli come questi utili alle persone e sentiamo una profonda responsabilità per farlo bene. Per fare progressi, abbiamo bisogno che le persone sperimentino la tecnologia e forniscano feedback. Abbiamo aperto LaMDA a migliaia di Googler, che si sono divertiti a testarlo e a vederne le capacità. Ciò ha prodotto significativi miglioramenti della qualità e ha portato a una riduzione delle risposte imprecise o offensive. Ecco perché abbiamo creato AI Test Kitchen. È un nuovo modo di esplorare le funzionalità dell’IA con un pubblico più ampio. All’interno della AI Test Kitchen, ci sono alcune esperienze diverse. Ognuno ha lo scopo di darti un’idea di come potrebbe essere avere LaMDA nelle tue mani e usarlo per le cose a cui tieni. Il primo si chiama “Immagina”. Questa demo verifica se il modello può prendere un’idea creativa che gli dai e generare descrizioni fantasiose e pertinenti. Questi non sono prodotti, sono brevi schizzi che ci permettono di esplorare ciò che LaMDA può fare con te. Le interfacce utente sono molto semplici” – hanno dichiarato.

“Supponiamo che tu stia scrivendo una storia e hai bisogno di alcune idee ispiratrici. Forse uno dei tuoi personaggi sta esplorando l’oceano profondo. Puoi chiedere come potrebbe essere. Qui LaMDA descrive una scena nella Fossa delle Marianne. Genera anche domande di follow-up al volo. Puoi chiedere a LaMDA di immaginare che tipo di creature potrebbero vivere lì. Ricorda, non abbiamo programmato manualmente il modello per argomenti specifici come i sottomarini o la bioluminescenza. Ha sintetizzato questi concetti dai suoi dati di addestramento. Ecco perché puoi chiedere su quasi tutti gli argomenti: gli anelli di Saturno o persino l’essere su un pianeta fatto di gelato. Rimanere in tema è una sfida per i modelli linguistici. Supponiamo che tu stia costruendo un’esperienza di apprendimento: vuoi che sia abbastanza aperta da consentire alle persone di esplorare dove li porta la curiosità, ma rimani al sicuro sull’argomento. La nostra seconda demo testa come LaMDA fa con quello. In questa demo, abbiamo preparato il modello per concentrarsi sul tema dei cani. Inizia generando una domanda per avviare la conversazione: “Ti sei mai chiesto perché i cani amano giocare a prendere così tanto?” E se fai una domanda di follow-up, ottieni una risposta con alcuni dettagli rilevanti: è interessante, pensa che potrebbe avere qualcosa a che fare con l’olfatto e la caccia al tesoro”.

“Puoi portare la conversazione dove vuoi. Forse sei curioso di sapere come funziona l’olfatto e vuoi immergerti più a fondo. Riceverai una risposta unica anche per questo. Non importa quello che chiedi, cercherà di mantenere la conversazione sull’argomento dei cani. Se comincio a chiedere del cricket, cosa che probabilmente lo farei, il modello riporta l’argomento ai cani in modo divertente. Questa sfida di rimanere in tema è complicata ed è un’area di ricerca importante per la creazione di applicazioni utili con modelli linguistici. Queste esperienze mostrano il potenziale dei modelli linguistici per aiutarci un giorno con cose come la pianificazione, l’apprendimento del mondo e altro ancora. Naturalmente, ci sono sfide significative da risolvere prima che questi modelli possano essere veramente utili. Sebbene abbiamo migliorato la sicurezza, il modello potrebbe comunque generare risposte imprecise, inappropriate o offensive. Ecco perché stiamo invitando feedback nell’app, in modo che le persone possano aiutare a segnalare problemi. Faremo tutto questo lavoro in conformità con i nostri Principi di intelligenza artificiale. Il nostro processo sarà iterativo, aprirà l’accesso nei prossimi mesi e valuterà attentamente il feedback con un’ampia gamma di parti interessate, dai ricercatori di intelligenza artificiale e scienziati sociali agli esperti di diritti umani. Incorporeremo questo feedback nelle versioni future di LaMDA e condivideremo i nostri risultati man mano che procediamo. Nel tempo, intendiamo continuare ad aggiungere altre aree emergenti dell’IA in AI Test Kitchen. Puoi saperne di più su: g.co/AITestKitchen“.

Modelli linguistici avanzati di intelligenza artificiale

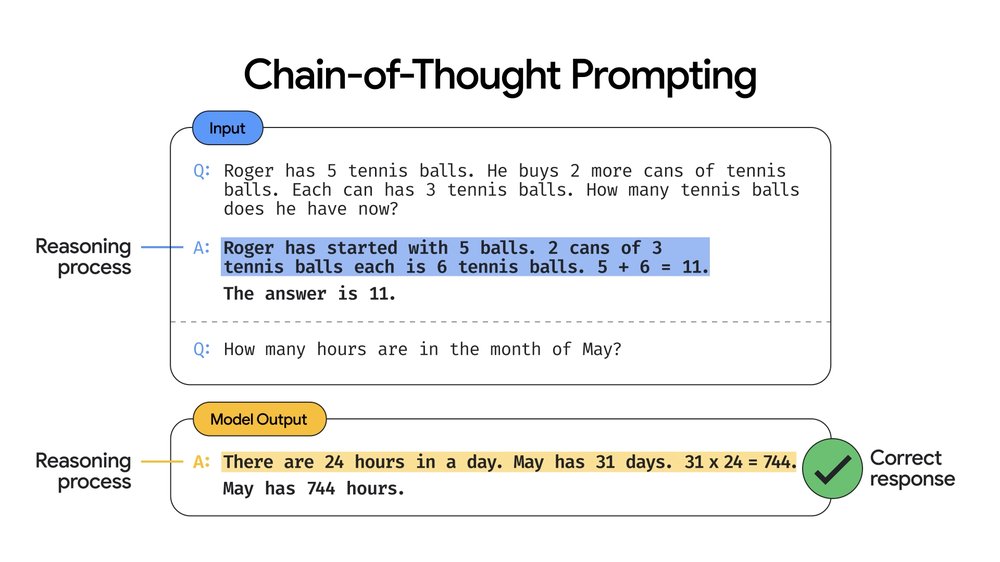

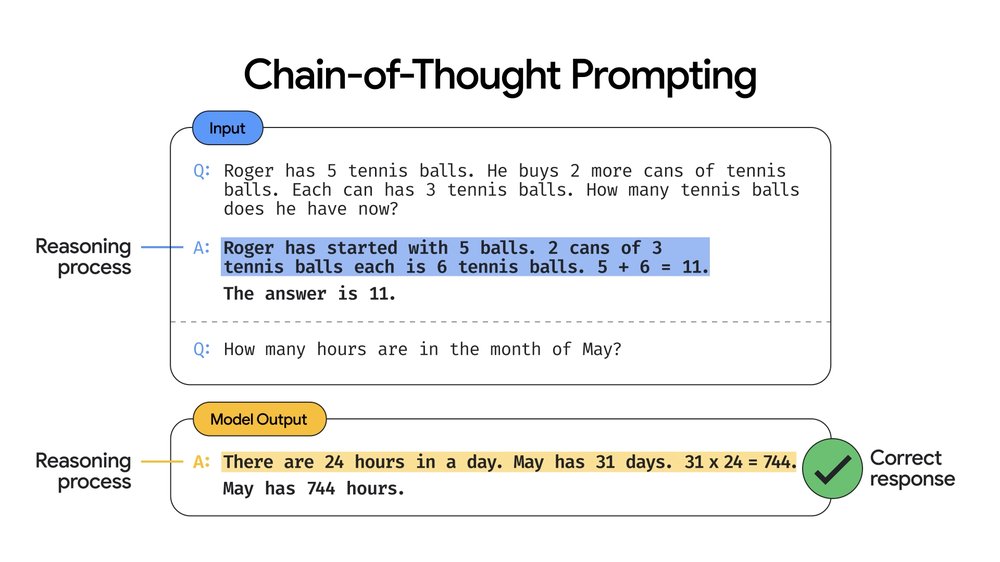

“LaMDA 2 ha incredibili capacità di conversazione. Per esplorare altri aspetti dell’elaborazione del linguaggio naturale e dell’IA, abbiamo recentemente annunciato un nuovo modello. Si chiama Pathways Language Model , o in breve PaLM. È il nostro modello più grande fino ad oggi e addestrato su 540 miliardi di parametri. PaLM dimostra prestazioni rivoluzionarie su molte attività di elaborazione del linguaggio naturale, come la generazione di codice dal testo, la risposta a un problema di parole matematiche o persino la spiegazione di una barzelletta. Raggiunge questo attraverso una scala più ampia. E quando combiniamo quella scala con una nuova tecnica chiamata suggerimento della catena di pensieri, i risultati sono promettenti. Il suggerimento della catena di pensiero ci consente di descrivere i problemi a più fasi come una serie di passaggi intermedi. Prendiamo un esempio di un problema di parole matematiche che richiede un ragionamento. Normalmente, il modo in cui si utilizza un modello è richiederlo con una domanda e una risposta e quindi iniziare a porre domande. In questo caso: quante ore ci sono nel mese di maggio? Quindi puoi vedere, il modello non ha capito bene. Nel suggerimento della catena di pensieri, diamo al modello una coppia domanda-risposta, ma questa volta una spiegazione di come è stata derivata la risposta. Un po’ come quando il tuo insegnante ti fornisce un esempio passo dopo passo per aiutarti a capire come risolvere un problema. Ora, se chiediamo di nuovo al modello – quante ore sono nel mese di maggio – o altre domande correlate, in realtà risponde correttamente e mostra persino il suo lavoro”.

“Il suggerimento della catena di pensiero porta a un ragionamento migliore e a risposte più accurate. Il suggerimento della catena di pensieri aumenta la precisione di un ampio margine. Ciò porta a prestazioni all’avanguardia attraverso diversi benchmark di ragionamento, inclusi problemi di parole matematiche. E possiamo fare tutto senza mai cambiare il modo in cui il modello viene addestrato. PaLM è altamente capace e può fare molto di più. Ad esempio, potresti essere qualcuno che parla una lingua che oggi non è ben rappresentata sul Web, il che rende difficile trovare informazioni. Ancora più frustrante perché la risposta che stai cercando è probabilmente là fuori. PaLM offre un nuovo approccio che offre enormi promesse per rendere la conoscenza più accessibile a tutti. Lascia che ti mostri un esempio in cui possiamo aiutare a rispondere alle domande in una lingua come il bengalese, parlata da un quarto di miliardo di persone. Proprio come prima, suggeriamo al modello due esempi di domande in bengalese con risposte sia in bengalese che in inglese. Ecco fatto, ora possiamo iniziare a fare domande in bengalese: “Qual è la canzone nazionale del Bangladesh?” La risposta, a proposito, è “Amar Sonar Bangla” – e anche PaLM ha capito bene. Questo non è così sorprendente perché ti aspetteresti che quel contenuto esista in bengalese. Puoi anche provare qualcosa che ha meno probabilità di avere informazioni correlate in bengalese come: “Quali sono i condimenti per pizza popolari a New York City?” Il modello risponde di nuovo correttamente in bengalese. Anche se probabilmente ha solo suscitato un dibattito tra i newyorkesi su quanto sia “corretta” quella risposta. Ciò che è così impressionante è che PaLM non ha mai visto frasi parallele tra bengalese e inglese. Né è mai stato insegnato esplicitamente a rispondere alle domande oa tradurre affatto! Il modello ha riunito tutte le sue capacità per rispondere correttamente alle domande in bengalese. E possiamo estendere le tecniche a più lingue e altri compiti complessi”.

“Siamo così ottimisti sul potenziale dei modelli linguistici. Un giorno, speriamo di poter rispondere a domande su più argomenti in qualsiasi lingua parli, rendendo la conoscenza ancora più accessibile, nella Ricerca e in tutto Google”.

Presentazione dell’hub di machine learning più grande e pubblicamente disponibile al mondo

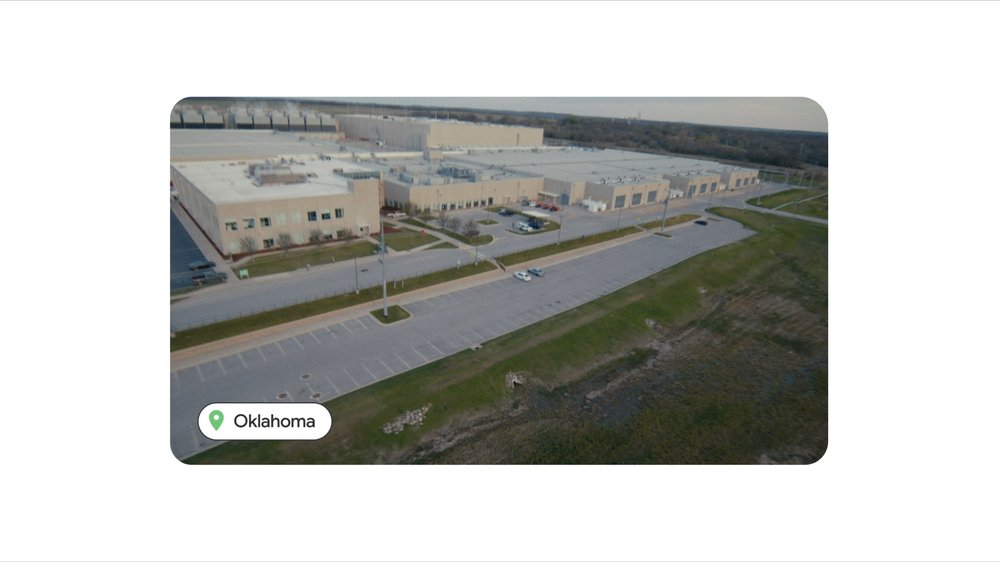

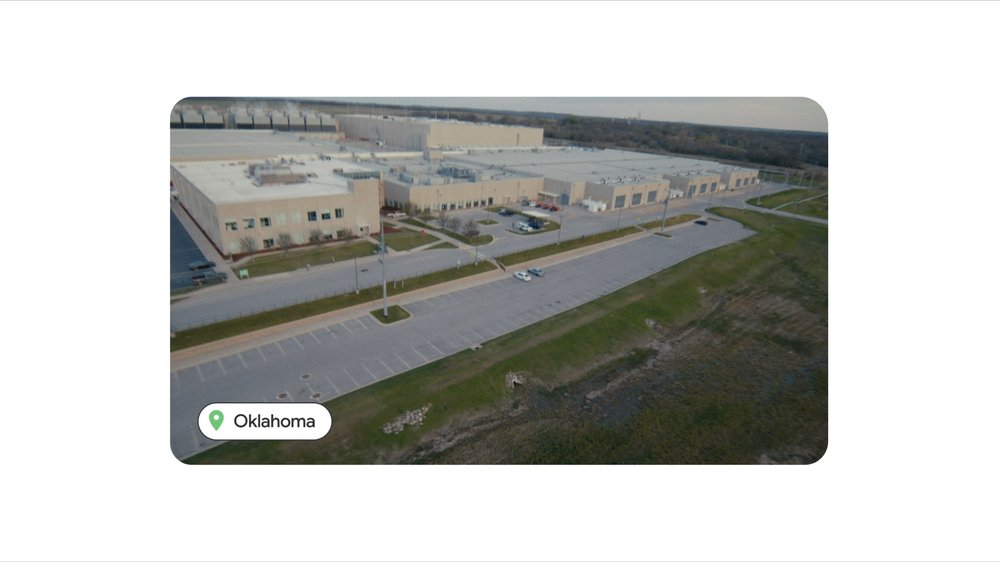

“I progressi che abbiamo condiviso oggi sono possibili solo grazie alla nostra continua innovazione nella nostra infrastruttura. Di recente abbiamo annunciato l’intenzione di investire 9,5 miliardi di dollari in data center e uffici negli Stati Uniti. Uno dei nostri data center all’avanguardia si trova nella contea di Mayes, in Oklahoma. Sono lieto di annunciare che stiamo lanciando il più grande hub di machine learning disponibile pubblicamente al mondo per i nostri clienti Google Cloud”.

“Uno dei nostri data center all’avanguardia nella contea di Mayes, in Oklahoma. Questo hub di machine learning ha otto pod Cloud TPU v4, costruiti su misura sulla stessa infrastruttura di rete che alimenta i più grandi modelli neurali di Google. Forniscono quasi nove exaflop di potenza di calcolo in totale, offrendo ai nostri clienti una capacità senza precedenti di eseguire modelli e carichi di lavoro complessi. Ci auguriamo che questo alimenterà l’innovazione in molti campi, dalla medicina alla logistica, alla sostenibilità e altro ancora. E parlando di sostenibilità, questo hub di apprendimento automatico funziona già con il 90% di energia priva di emissioni di carbonio. Questo ci sta aiutando a compiere progressi nel nostro obiettivo di diventare la prima grande azienda a gestire tutti i nostri data center e campus a livello globale con energia priva di emissioni di carbonio 24 ore su 24, 7 giorni su 7 entro il 2030”.

“Anche se investiamo nei nostri data center, stiamo lavorando per innovare sulle nostre piattaforme mobili in modo che una maggiore elaborazione possa avvenire localmente sul dispositivo. Google Tensor, il nostro sistema personalizzato su chip, è stato un passo importante in questa direzione. È già in esecuzione su Pixel 6 e Pixel 6 Pro e porta le nostre capacità di intelligenza artificiale, incluso il miglior riconoscimento vocale che abbiamo mai implementato, direttamente sul tuo telefono. È anche un grande passo avanti nel rendere questi dispositivi più sicuri. In combinazione con Private Compute Core di Android, può eseguire funzionalità basate sui dati direttamente sul dispositivo in modo che sia privato per te. Le persone si rivolgono ai nostri prodotti ogni giorno per chiedere aiuto nei momenti grandi e piccoli. Il fulcro per renderlo possibile è proteggere le tue informazioni private in ogni fase del processo. Anche se la tecnologia diventa sempre più complessa, teniamo al sicuro più persone online di chiunque altro al mondo, con prodotti che sono sicuri per impostazione predefinita, privati per progettazione e che ti danno il controllo”.

“Oggi abbiamo anche passato del tempo a condividere aggiornamenti su piattaforme come Android . Stanno fornendo accesso, connettività e informazioni a miliardi di persone attraverso i loro smartphone e altri dispositivi connessi come TV, automobili e orologi”.

“E abbiamo condiviso il nostro nuovo portafoglio Pixel, inclusi Pixel 6a, Pixel Buds Pro, Google Pixel Watch, Pixel 7 e Pixel tablet, tutti progettati pensando all’ambient computing. Siamo entusiasti di condividere una famiglia di dispositivi che funzionano meglio insieme, per te”

La prossima frontiera dell’informatica: la realtà aumentata

“Oggi abbiamo parlato di tutte le tecnologie che stanno cambiando il modo in cui utilizziamo i computer e accediamo alla conoscenza. Vediamo i dispositivi che funzionano perfettamente insieme, esattamente quando e dove ne hai bisogno e con interfacce di conversazione che rendono più facile fare le cose. Guardando al futuro, c’è una nuova frontiera dell’informatica, che ha il potenziale per estendere tutto questo ancora di più, ed è la realtà aumentata. In Google, abbiamo investito molto in questo settore. Abbiamo integrato la realtà aumentata in molti prodotti Google, da Google Lens alla ricerca multipla, all’esplorazione di scene e alle viste dal vivo e immersive in Maps. Queste capacità AR sono già utili sui telefoni e la magia prenderà vita quando potrai usarle nel mondo reale senza che la tecnologia si intrometta. Questo potenziale è ciò che ci rende più entusiasti dell’AR: la capacità di trascorrere del tempo concentrandosi su ciò che conta nel mondo reale, nella nostra vita reale. Perché il mondo reale è davvero sorprendente! È importante progettare in un modo che sia costruito per il mondo reale e non ti allontani da esso. E AR ci offre nuovi modi per raggiungere questo obiettivo. Prendiamo la lingua come esempio. Il linguaggio è così fondamentale per connettersi l’uno con l’altro. Eppure, capire qualcuno che parla una lingua diversa o provare a seguire una conversazione se sei sordo o con problemi di udito può essere una vera sfida. Vediamo cosa succede quando prendiamo i nostri progressi nella traduzione e nella trascrizione e li consegniamo nella tua linea di vista in uno dei primi prototipi che abbiamo testato”.

“Puoi vederlo nei loro volti: la gioia che deriva dal parlare in modo naturale a qualcuno. Quel momento di connessione. Per capire ed essere capito. Questo è ciò su cui si concentra la nostra attenzione sulla conoscenza e sull’informatica. Ed è ciò per cui ci impegniamo ogni giorno, con prodotti creati per aiutare. Ogni anno ci avviciniamo un po’ alla realizzazione della nostra missione senza tempo. E abbiamo ancora molto altro da fare. In Google, proviamo davvero un senso di eccitazione per questo. E siamo ottimisti sul fatto che le scoperte che hai appena visto ci aiuteranno ad arrivarci. Grazie a tutti gli sviluppatori, partner e clienti che si sono uniti a noi oggi. Non vediamo l’ora di costruire il futuro con tutti voi” – hanno concluso da Google: